Train

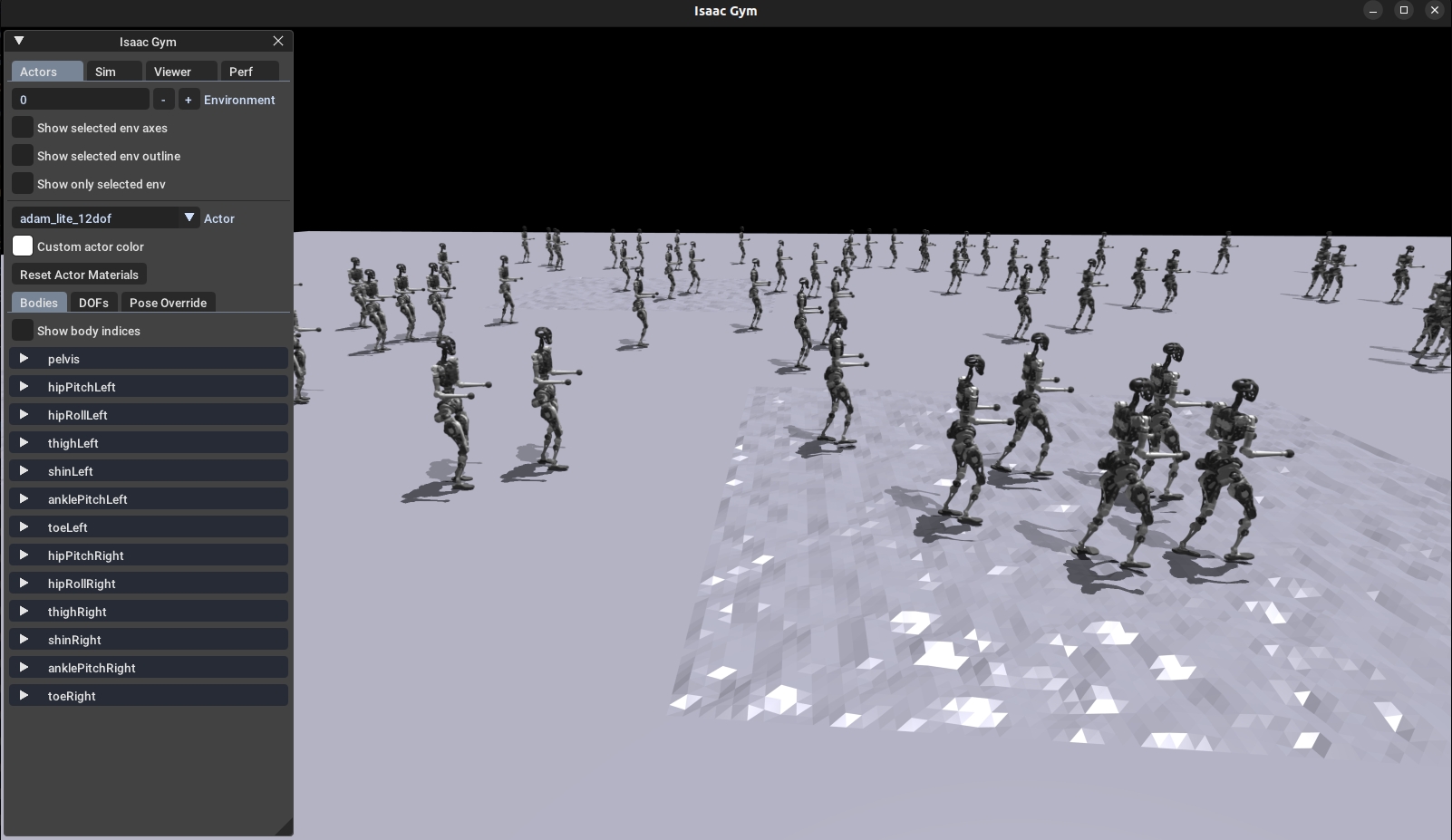

本文介绍了通过 Gym 仿真环境,让机器人与环境互动,找到最满足奖励设计的策略。通常不推荐实时查看效果,以免降低训练效率。

运行以下命令开始训练:

图形界面渲染会导致训练速度减慢,在IsaacGym的界面中按键盘上的 V 键,可以暂停渲染,加快训练速度。如果想要查看训练的效果可以再次按 V 键,重新开启渲染。

参数说明

--task: 必选参数,值可选(目前支持型号 adam_lite_12dof)--headless: 不设置该参数时默认启动图形界面,设为 true 时不渲染图形界面(效率更高)--resume: 从日志中选择 checkpoint 继续训练--experiment_name: 运行/加载的 experiment 名称--run_name: 运行/加载的 run 名称--load_run: 加载运行的名称,默认加载最后一次运行--checkpoint: checkpoint 编号,默认加载最新一次文件--num_envs: 并行训练的环境个数--seed: 随机种子--max_iterations: 训练的最大迭代次数--sim_device: 仿真计算设备,指定 CPU 为--sim_device=cpu--rl_device: 强化学习计算设备,指定 CPU 为--rl_device=cpu

默认保存训练结果:logs/<experiment_name>/<date_time>_<run_name>/model_<iteration>.pt